Mehrfache Redundanz

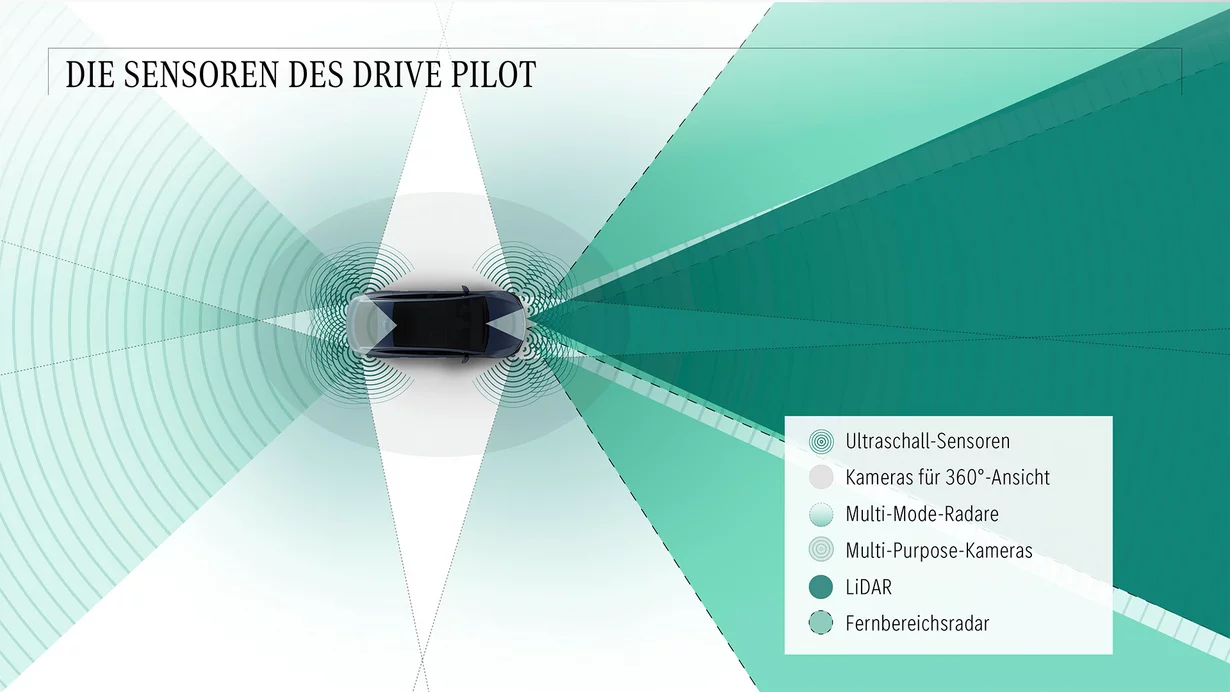

Das Hauptziel der Weiterentwicklung der Fahrerassistenzsysteme FAS liegt auf der Hand: Im Strassenverkehr sollen Personenschäden oder gar Tote vermieden werden. Um dies zu erreichen, sollen die Menschen hinter dem Lenkrad von der Technik so unterstützt werden, dass die Wahrnehmungsmöglichkeiten wie sehen und hören mittels Fahrzeugsensorik ergänzt und unterstützt werden. Modernste FAS bedienen sich dazu mehrerer Umgebungssensoren, welche redundant ausgeführt sind. Für das Vorfeld sind heute längst nicht mehr nur Frontkamera hinter der Windschutzscheibe und Radar an der Fahrzeugfront zuständig. Ergänzt werden die beiden von Solid-State-Lidars, welche keine beweglichen Bauteile mehr aufweisen und deshalb robuster für den Einsatz im Fahrzeug sind als Lidare mit beweglichen Teilen wie Spiegel, um die elektromagnetischen Wellen in einem breiten Feld vor dem Fahrzeug auszusenden.

Die Abkürzung Lidar bedeutet auf Englisch «Light Detection and Ranging» und umfasst eine Technologie zur präzisen Entfernungsmessung mittels Laserimpulse, die dreidimensionale Strukturen und Oberflächen erfassen kann. Der Sensor ist in der Lage, nicht nur die Distanzen zu bestimmen, sondern auch dank der 3-D-Punktwolke ein farbiges Bild zu erstellen, das die Umrisse von Objekten wie Fussgänger usw. erlaubt. Der Sensor kann im übertragenen Sinn die Aufgabe von Frontkamera und Radar in einem Bauteil übernehmen. Während die Frontkamera einzig Bildpunkte erfasst und die Auswertesoftware aus den Bilder Objekte kategorisieren kann, ist der Radar in der Lage, präzise Ortung von Objekten zu ermöglichen. Der Radar erfasst sowohl die Relativgeschwindigkeit zu einem Objekt wie die Distanz und den Winkel zum eigenen Fahrzeug.

Werden die drei Sensoren bei modernen Fahrzeugen in Form von einer Sensordatenfusion in einem zentralen Steuergerät ausgewertet, kann das System aufgrund der unabhängigen Auswertung von Radar/Frontkamera und Lidar die Wahrscheinlichkeit deutlich erhöhen, Objekte korrekt zu erkennen und daraus abgeleitet die richtigen Warn- oder Regeleingriffe einzuleiten. Die Weiterentwicklung der drei Sensorarten begünstigt zudem, Fehlentscheide zu minimieren. Bei den Kameras steigt die Auflösung und damit die Anzahl der Bildpunkte pro Fläche und vermehrt gelangen Stereokameras zum Einsatz, um das menschliche Sehen zu simulieren. Durch die beiden Kameras entsteht ein dreidimensionales Erfassungsbild, bei dem auch Distanzen vom System bestimmt werden können. Im Weiteren wird die Bildverarbeitung im Sensor durch beschleunigte Prozessgeschwindigkeit verbessert und damit die Objekterkennung stetig optimiert. Bei den Radarsensoren erweitern die Zulieferer die bisher bekannten 77-GHz-Sensoren mit neuen 120-GHz-Sensoren, die beinahe eine doppelte Anzahl von Messungen pro Zeiteinheit durchführen können. Die neue Radargeneration ist zudem in der Lage, bei ungünstigen Wetterbedingungen wie Regen oder Schneefall zuverlässigere Messungen mit einem Winkelabstand von 1° durchzuführen. Bei einfachen FMCW-Radarsystemen wurden nebst der Relativgeschwindigkeit und der Winkellage (horizontale Messung, Azimutwinkel) die Distanz bestimmt.